Hyperparameter Optimization란?

(HPO)

주어진 목적 함수를 최대/최소화 하는 최적의 파라미터 탐색하는 행위

최대화

정확도

F1-Score

최소화

MAE

MSE

최적의 파라미터를 탐색 알고리즘

Grid SEarch

Random Search

Bayesian Search

...

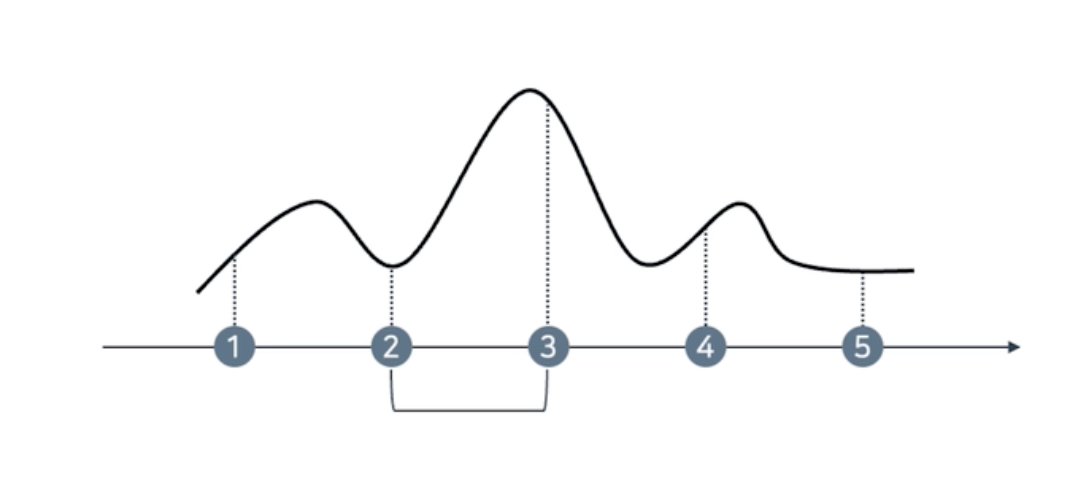

grid

격자로 최적의 파라미터

10~100범위

10 20 30 40 실험 진행

단점 : 제일 성능이 좋은 범위를 벗어 날 수 있음

random

난수를 추출

처음에는 grid를 활용해 가장 값이 높은 범위를 탐색

2~3으로 줄임

2와 3 사이에서 random하게 해서 가장 좋은 값을 찾음

1. grid

2. random

HPO 라이브러리

HPO를 효율적으로 진행하기 위해

1. 적절한 파라미터 후보군 추출

OPTUNA, RAY

2. 컴퓨팅 자원의 효율적 사용

RAY

OPTUNA가 두개의 후보군을 선정

RAY가 각각의 서버에 전달하게 해서 실험을 수행하게 함

실험이 끝나면 결과값을 옵튜나에게, 옵튜나는 결과값을 바탕으로 파라미터 후보군을 추출함.

'Tech Stack > MLflow' 카테고리의 다른 글

| MLOps - 교차검증 (0) | 2024.02.23 |

|---|---|

| MLOps - HPO 반영 (0) | 2024.02.22 |

| MLOps - Optuna (0) | 2024.02.22 |

| MLOps - 학습 코드 로깅 추가 (0) | 2024.02.22 |

| MLOps - MLflow 실행 및 docker compose (0) | 2024.02.22 |